gpu编程技术gpu编程递归

深度学习

2024-05-09 03:30

1067

联系人:

联系方式:

GPU编程中的递归:原理、应用与优化

一、引言

随着计算机图形学和人工智能等领域的快速发展,图形处理器(GPU)在计算密集型任务中发挥着越来越重要的作用。传统的CPU编程在处理大规模数据时往往受限于其并行处理能力,而GPU则具有高度并行的特性,能够同时执行数千个线程,从而显著提高计算性能。然而,由于GPU的架构和编程模型与CPU存在较大差异,如何在GPU上进行高效的编程成为了一个亟待解决的问题。本文将探讨GPU编程中的递归技术,分析其在GPU上的实现原理、应用场景以及优化策略。

二、GPU编程中的递归原理

- GPU架构与编程模型

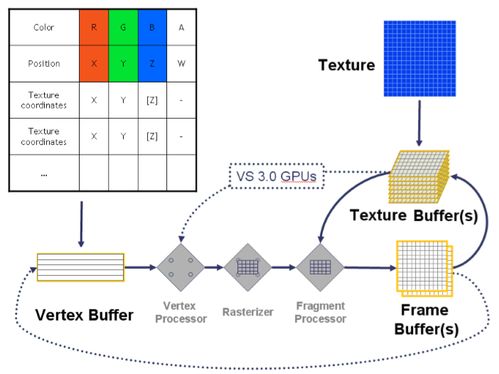

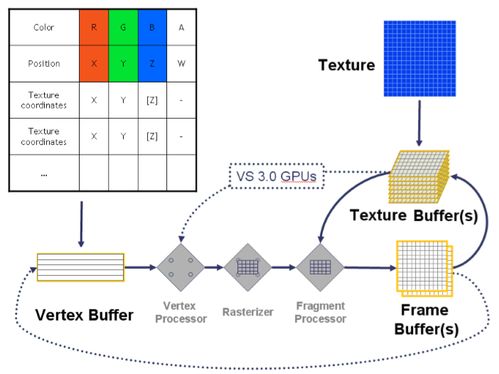

GPU主要由多个流处理器组成,每个流处理器可以同时执行多个线程。这种架构使得GPU非常适合处理大量并行且相互独立的任务。在GPU编程中,通常使用类似于C语言的着色器语言来编写程序,并通过特定的API(如OpenGL或CUDA)将程序上传至GPU执行。

- 递归在GPU上的实现

递归是一种常见的编程技巧,通过函数调用自身来实现对问题的分解和求解。在CPU上,递归函数的执行依赖于栈结构来保存中间状态和局部变量。然而,GPU并没有提供类似的栈结构,因此无法直接支持递归。为了在GPU上实现递归,通常需要采用尾递归优化、循环展开或者显式地管理堆栈等方法。

三、GPU编程中递归的应用场景

- 图像处理与计算机视觉

在图像处理和计算机视觉领域,递归算法被广泛应用于图像滤波、边缘检测、特征提取等任务。例如,高斯滤波可以通过递归的方式实现卷积操作,从而加速图像平滑过程;Sobel算子可以利用递归进行边缘检测,提高计算效率。

- 图形学与渲染管线

在图形学中,递归经常被用于实现光线追踪、阴影计算等复杂的光照效果。通过递归遍历场景中的物体和光源,可以实现逼真的光照模拟。递归还可以应用于几何体的细分和建模过程中,如递归细分曲面生成等。

- 机器学习与深度学习

在机器学习和深度学习中,递归神经网络(RNN)是一类重要的模型,它利用递归结构来处理序列数据,如自然语言处理和时间序列预测等任务。虽然RNN通常在CPU上实现,但近年来也有研究尝试将其移植到GPU上以获得更高的计算性能。

四、GPU编程中递归的优化策略

- 尾递归优化

尾递归是指递归调用在函数的最后一步执行,此时不需要额外的栈空间来保存中间状态。通过将非尾递归转换为尾递归,可以减少递归过程中的栈开销,提高程序的执行效率。

- 循环展开与并行化

对于某些递归算法,可以尝试将其转换为迭代形式并进行循环展开。这样不仅可以减少递归次数,还可以通过并行化进一步提高计算性能。例如,可以将递归的二分查找算法转换为迭代形式,并在GPU上并行执行多个查找任务。

- 显式堆栈管理

在某些情况下,可以考虑显式地在GPU上实现堆栈结构来支持递归。这种方法需要手动管理堆栈的压入和弹出操作,以确保递归的正确性和高效性。然而,这通常会增加编程复杂度和内存开销,因此在实际应用中需要权衡利弊。

五、总结与展望

本文介绍了GPU编程中递归的原理、应用场景以及优化策略。尽管GPU本身并不支持递归,但通过一些巧妙的编程技巧和方法,我们仍然可以在GPU上实现高效的递归算法。展望未来,随着GPU架构的不断演进和编程技术的不断创新,我们有理由相信GPU将在更多领域发挥重要作用,为各类计算密集型任务提供强大的支持。

GPU编程中的递归:原理、应用与优化

一、引言

随着计算机图形学和人工智能等领域的快速发展,图形处理器(GPU)在计算密集型任务中发挥着越来越重要的作用。传统的CPU编程在处理大规模数据时往往受限于其并行处理能力,而GPU则具有高度并行的特性,能够同时执行数千个线程,从而显著提高计算性能。然而,由于GPU的架构和编程模型与CPU存在较大差异,如何在GPU上进行高效的编程成为了一个亟待解决的问题。本文将探讨GPU编程中的递归技术,分析其在GPU上的实现原理、应用场景以及优化策略。

二、GPU编程中的递归原理

- GPU架构与编程模型

GPU主要由多个流处理器组成,每个流处理器可以同时执行多个线程。这种架构使得GPU非常适合处理大量并行且相互独立的任务。在GPU编程中,通常使用类似于C语言的着色器语言来编写程序,并通过特定的API(如OpenGL或CUDA)将程序上传至GPU执行。

- 递归在GPU上的实现

递归是一种常见的编程技巧,通过函数调用自身来实现对问题的分解和求解。在CPU上,递归函数的执行依赖于栈结构来保存中间状态和局部变量。然而,GPU并没有提供类似的栈结构,因此无法直接支持递归。为了在GPU上实现递归,通常需要采用尾递归优化、循环展开或者显式地管理堆栈等方法。

三、GPU编程中递归的应用场景

- 图像处理与计算机视觉

在图像处理和计算机视觉领域,递归算法被广泛应用于图像滤波、边缘检测、特征提取等任务。例如,高斯滤波可以通过递归的方式实现卷积操作,从而加速图像平滑过程;Sobel算子可以利用递归进行边缘检测,提高计算效率。

- 图形学与渲染管线

在图形学中,递归经常被用于实现光线追踪、阴影计算等复杂的光照效果。通过递归遍历场景中的物体和光源,可以实现逼真的光照模拟。递归还可以应用于几何体的细分和建模过程中,如递归细分曲面生成等。

- 机器学习与深度学习

在机器学习和深度学习中,递归神经网络(RNN)是一类重要的模型,它利用递归结构来处理序列数据,如自然语言处理和时间序列预测等任务。虽然RNN通常在CPU上实现,但近年来也有研究尝试将其移植到GPU上以获得更高的计算性能。

四、GPU编程中递归的优化策略

- 尾递归优化

尾递归是指递归调用在函数的最后一步执行,此时不需要额外的栈空间来保存中间状态。通过将非尾递归转换为尾递归,可以减少递归过程中的栈开销,提高程序的执行效率。

- 循环展开与并行化

对于某些递归算法,可以尝试将其转换为迭代形式并进行循环展开。这样不仅可以减少递归次数,还可以通过并行化进一步提高计算性能。例如,可以将递归的二分查找算法转换为迭代形式,并在GPU上并行执行多个查找任务。

- 显式堆栈管理

在某些情况下,可以考虑显式地在GPU上实现堆栈结构来支持递归。这种方法需要手动管理堆栈的压入和弹出操作,以确保递归的正确性和高效性。然而,这通常会增加编程复杂度和内存开销,因此在实际应用中需要权衡利弊。

五、总结与展望

本文介绍了GPU编程中递归的原理、应用场景以及优化策略。尽管GPU本身并不支持递归,但通过一些巧妙的编程技巧和方法,我们仍然可以在GPU上实现高效的递归算法。展望未来,随着GPU架构的不断演进和编程技术的不断创新,我们有理由相信GPU将在更多领域发挥重要作用,为各类计算密集型任务提供强大的支持。