跨机器使用TensorFlow进行分布式训练如何调用其他机器的GPU资源

深度学习

2024-07-16 13:40

829

联系人:

联系方式:

随着深度学习模型的不断增长和复杂化,单台机器的计算能力往往无法满足大规模训练的需求。为了加速模型的训练过程,我们可以利用多台机器上的GPU资源进行分布式训练。本文将介绍如何在TensorFlow中实现这一目标。

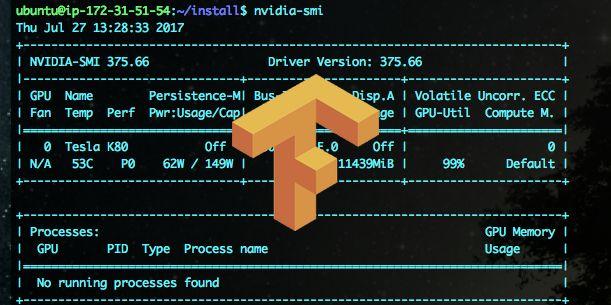

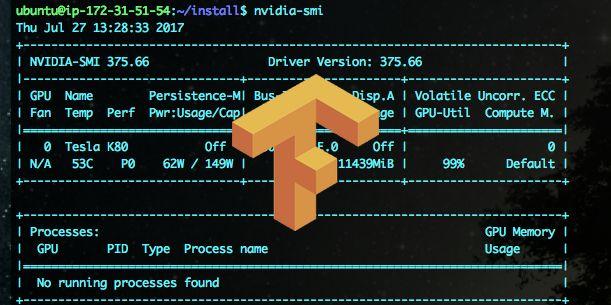

我们需要确保所有参与训练的机器都安装了相同版本的TensorFlow,并且可以通过网络相互通信。每台机器上都需要安装NVIDIA驱动程序、CUDA Toolkit和cuDNN库,以便支持GPU加速。

我们将使用TensorFlow提供的分布式策略API来实现跨机器的分布式训练。具体来说,我们将使用ParameterServerStrategy或MirroredStrategy等策略来管理模型参数和计算任务在多台机器之间的分配。

以下是一个简单的示例,展示了如何使用ParameterServerStrategy进行分布式训练:

import tensorflow as tf

# 配置分布式策略

strategy = tf.distribute.experimental.ParameterServerStrategy()

# 创建全局步数变量

global_step = tf.Variable(0, trainable=False)

# 定义模型

def create_model():

model = tf.keras.Sequential([

tf.keras.layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),

tf.keras.layers.MaxPooling2D((2, 2)),

tf.keras.layers.Flatten(),

tf.keras.layers.Dense(64, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

return model

# 获取当前任务的上下文

with strategy.scope():

# 在当前任务中创建模型

model = create_model()

# 编译模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

# 准备数据集

mnist = tf.keras.datasets.mnist

(x_train, y_train), (x_test, y_test) = mnist.load_data()

x_train, x_test = x_train / 255.0, x_test / 255.0

x_train = x_train[..., None]

x_test = x_test[..., None]

# 训练模型

model.fit(x_train, y_train, epochs=5, steps_per_epoch=100, validation_data=(x_test, y_test))

在上述代码中,我们首先通过tf.distribute.experimental.ParameterServerStrategy()创建了一个分布式策略对象。我们在该策略的作用域内创建了模型,并将模型参数存储在参数服务器上。我们使用model.fit()方法开始训练模型。

需要注意的是,上述示例中的代码需要在所有参与训练的机器上运行。为了确保模型参数在不同机器之间同步,我们需要设置合适的同步策略(如异步更新或同步更新)。在实际应用中,还需要考虑网络带宽、延迟等因素对训练速度的影响,并进行相应的优化。

随着深度学习模型的不断增长和复杂化,单台机器的计算能力往往无法满足大规模训练的需求。为了加速模型的训练过程,我们可以利用多台机器上的GPU资源进行分布式训练。本文将介绍如何在TensorFlow中实现这一目标。

我们需要确保所有参与训练的机器都安装了相同版本的TensorFlow,并且可以通过网络相互通信。每台机器上都需要安装NVIDIA驱动程序、CUDA Toolkit和cuDNN库,以便支持GPU加速。

我们将使用TensorFlow提供的分布式策略API来实现跨机器的分布式训练。具体来说,我们将使用ParameterServerStrategy或MirroredStrategy等策略来管理模型参数和计算任务在多台机器之间的分配。

以下是一个简单的示例,展示了如何使用ParameterServerStrategy进行分布式训练:

import tensorflow as tf

# 配置分布式策略

strategy = tf.distribute.experimental.ParameterServerStrategy()

# 创建全局步数变量

global_step = tf.Variable(0, trainable=False)

# 定义模型

def create_model():

model = tf.keras.Sequential([

tf.keras.layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),

tf.keras.layers.MaxPooling2D((2, 2)),

tf.keras.layers.Flatten(),

tf.keras.layers.Dense(64, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

return model

# 获取当前任务的上下文

with strategy.scope():

# 在当前任务中创建模型

model = create_model()

# 编译模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

# 准备数据集

mnist = tf.keras.datasets.mnist

(x_train, y_train), (x_test, y_test) = mnist.load_data()

x_train, x_test = x_train / 255.0, x_test / 255.0

x_train = x_train[..., None]

x_test = x_test[..., None]

# 训练模型

model.fit(x_train, y_train, epochs=5, steps_per_epoch=100, validation_data=(x_test, y_test))

在上述代码中,我们首先通过tf.distribute.experimental.ParameterServerStrategy()创建了一个分布式策略对象。我们在该策略的作用域内创建了模型,并将模型参数存储在参数服务器上。我们使用model.fit()方法开始训练模型。

需要注意的是,上述示例中的代码需要在所有参与训练的机器上运行。为了确保模型参数在不同机器之间同步,我们需要设置合适的同步策略(如异步更新或同步更新)。在实际应用中,还需要考虑网络带宽、延迟等因素对训练速度的影响,并进行相应的优化。