CUDA编程中的GPU选择与优化

算法模型

2024-05-29 11:30

491

联系人:

联系方式:

随着深度学习、高性能计算等领域的快速发展,图形处理器(GPU)已经成为了许多计算密集型任务的重要加速器。NVIDIA的CUDA(Compute Unified Device Architecture)平台为开发者提供了在GPU上执行并行计算的能力。然而,在使用CUDA时,合理地选择和配置GPU资源对于提升性能至关重要。本文将探讨如何在CUDA编程中指定和使用特定的GPU。

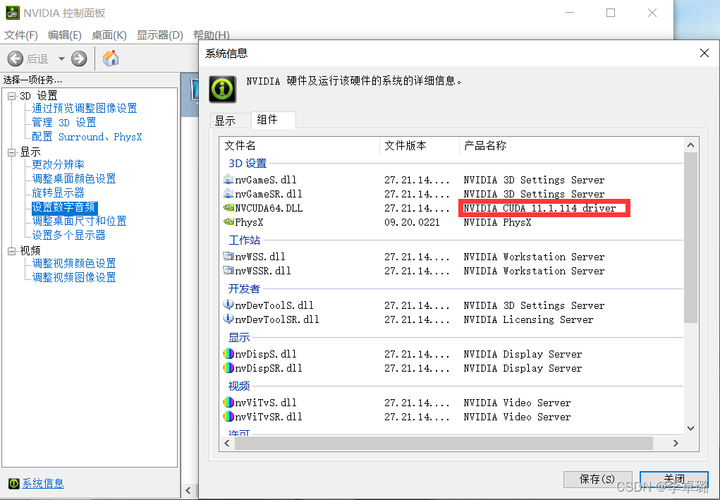

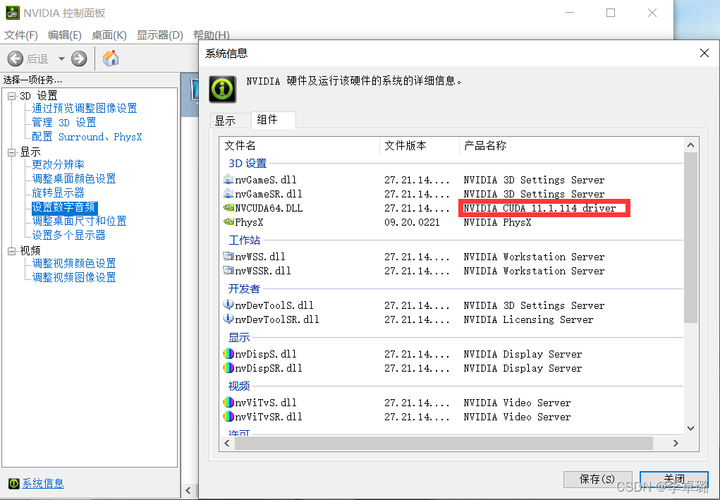

一、了解系统中的GPU设备

在进行CUDA编程之前,首先需要了解系统中可用的GPU设备及其特性。这可以通过运行nvidia-smi命令来实现,该命令会显示所有已安装的NVIDIA GPU的信息,包括型号、驱动版本、内存大小以及当前的负载情况。

二、CUDA API中的GPU选择

- 通过环境变量设置默认GPU

在Linux和Windows系统中,可以通过设置环境变量来指定CUDA程序使用的默认GPU。例如,在Linux中可以使用以下命令:

export CUDA_VISIBLE_DEVICES=0

这将使得编号为0的GPU成为CUDA程序可见的唯一设备。如果有多个GPU,可以将它们的编号用逗号分隔开来指定。

- 在CUDA代码中动态选择GPU

除了通过环境变量设置默认GPU外,还可以在CUDA代码中动态选择要使用的GPU。这可以通过调用cudaSetDevice()函数实现,该函数接受一个整数参数,表示目标GPU的编号。例如:

int gpu_id = 0; // 要使用的GPU编号

cudaSetDevice(gpu_id);

三、多GPU系统的优化策略

对于拥有多个GPU的系统,可以采用以下策略来优化CUDA程序的性能:

-

数据并行:将数据集分割成多个子集,并将每个子集分配给不同的GPU进行处理。这样可以同时利用多个GPU的计算能力,从而提高整体处理速度。

-

模型并行:将计算模型的不同部分分配给不同的GPU进行计算。这种方法适用于那些无法简单地将数据分割到多个GPU上的复杂计算任务。

-

流水线并行:将计算过程划分为多个阶段,并在不同的GPU上执行这些阶段。这样可以减少等待时间,提高资源的利用率。

四、总结

在使用CUDA进行GPU编程时,合理地选择和配置GPU资源对于提升性能至关重要。开发者应充分了解系统中的GPU设备及其特性,并通过环境变量或CUDA API灵活地指定要使用的GPU。针对多GPU系统,可以采用数据并行、模型并行和流水线并行等策略来进一步优化程序的性能。

随着深度学习、高性能计算等领域的快速发展,图形处理器(GPU)已经成为了许多计算密集型任务的重要加速器。NVIDIA的CUDA(Compute Unified Device Architecture)平台为开发者提供了在GPU上执行并行计算的能力。然而,在使用CUDA时,合理地选择和配置GPU资源对于提升性能至关重要。本文将探讨如何在CUDA编程中指定和使用特定的GPU。

一、了解系统中的GPU设备

在进行CUDA编程之前,首先需要了解系统中可用的GPU设备及其特性。这可以通过运行nvidia-smi命令来实现,该命令会显示所有已安装的NVIDIA GPU的信息,包括型号、驱动版本、内存大小以及当前的负载情况。

二、CUDA API中的GPU选择

- 通过环境变量设置默认GPU

在Linux和Windows系统中,可以通过设置环境变量来指定CUDA程序使用的默认GPU。例如,在Linux中可以使用以下命令:

export CUDA_VISIBLE_DEVICES=0

这将使得编号为0的GPU成为CUDA程序可见的唯一设备。如果有多个GPU,可以将它们的编号用逗号分隔开来指定。

- 在CUDA代码中动态选择GPU

除了通过环境变量设置默认GPU外,还可以在CUDA代码中动态选择要使用的GPU。这可以通过调用cudaSetDevice()函数实现,该函数接受一个整数参数,表示目标GPU的编号。例如:

int gpu_id = 0; // 要使用的GPU编号

cudaSetDevice(gpu_id);

三、多GPU系统的优化策略

对于拥有多个GPU的系统,可以采用以下策略来优化CUDA程序的性能:

-

数据并行:将数据集分割成多个子集,并将每个子集分配给不同的GPU进行处理。这样可以同时利用多个GPU的计算能力,从而提高整体处理速度。

-

模型并行:将计算模型的不同部分分配给不同的GPU进行计算。这种方法适用于那些无法简单地将数据分割到多个GPU上的复杂计算任务。

-

流水线并行:将计算过程划分为多个阶段,并在不同的GPU上执行这些阶段。这样可以减少等待时间,提高资源的利用率。

四、总结

在使用CUDA进行GPU编程时,合理地选择和配置GPU资源对于提升性能至关重要。开发者应充分了解系统中的GPU设备及其特性,并通过环境变量或CUDA API灵活地指定要使用的GPU。针对多GPU系统,可以采用数据并行、模型并行和流水线并行等策略来进一步优化程序的性能。