BERT模型的多GPU并行优化

算法模型

2024-07-30 18:40

1158

联系人:

联系方式:

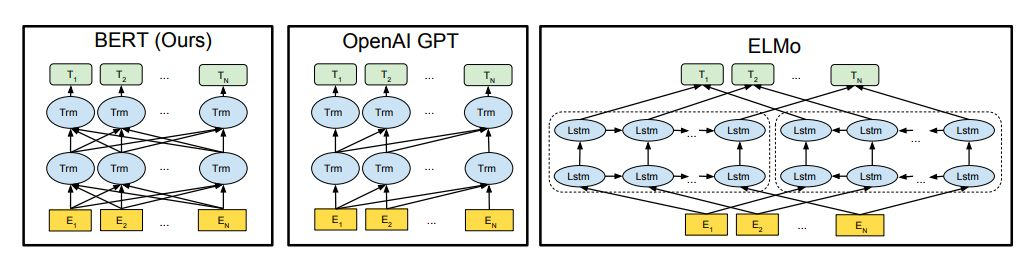

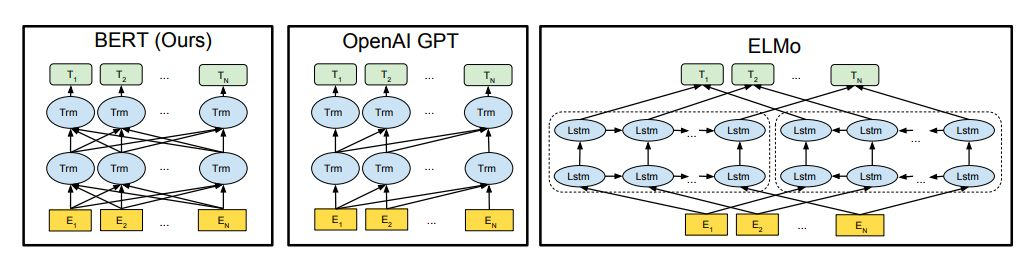

随着深度学习技术的飞速发展,预训练语言模型如BERT(Bidirectional Encoder Representations from Transformers)已成为自然语言处理领域的重要基石。然而,BERT模型由于其庞大的参数数量和复杂的计算需求,对计算资源的要求极高。为了加速BERT的训练过程,利用多个GPU进行并行计算成为了一种有效的解决方案。本文将探讨如何在多GPU环境下实现BERT模型的并行训练,以及如何优化这一过程以获得最佳性能。

一、多GPU并行原理

在单GPU环境中,所有的计算任务都在一个GPU上执行。而在多GPU环境中,可以将计算任务分配到多个GPU上同时进行,从而显著提高计算速度。具体来说,可以通过以下两种方式实现多GPU并行:

- 数据并行:将输入数据集分割成若干个子集,每个子集分配到一个GPU上进行计算。这种方式适用于大规模数据集,可以有效减少单个GPU的计算负担。

- 模型并行:将模型的不同部分分配到不同的GPU上进行计算。这种方式适用于模型规模较大的情况,可以避免单个GPU的显存不足问题。

二、BERT模型的多GPU并行实现

对于BERT模型而言,由于其Transformer结构的复杂性,通常采用数据并行的方式进行多GPU训练。以下是实现BERT模型多GPU并行的基本步骤:

- 数据准备:首先需要将输入数据集分割成若干个子集,每个子集包含相同数量的样本。这些子集将被分别发送到不同的GPU上进行训练。

- 初始化模型:在每个GPU上初始化一个相同的BERT模型副本。这些模型副本将在各自的GPU上进行前向传播和反向传播计算。

- 梯度同步:在每个训练批次结束后,需要将所有GPU上的模型副本的梯度进行同步。这可以通过求取所有梯度的平均值来实现,以确保不同GPU上的模型副本能够朝着同一方向更新权重。

- 权重更新:使用同步后的梯度对所有GPU上的模型副本进行权重更新。这一步骤可以确保所有模型副本在下一轮训练中具有相同的权重值。

- 重复以上步骤直至模型收敛。

三、多GPU并行优化策略

尽管多GPU并行可以显著提高BERT模型的训练速度,但如果不进行适当的优化,可能会遇到一些性能瓶颈。以下是一些常用的多GPU并行优化策略:

- 梯度累积:由于梯度同步操作的开销较大,可以通过累积多个训练批次的梯度后再进行一次同步来降低同步频率。这种方法可以在一定程度上缓解梯度同步带来的性能损失。

- 混合精度训练:使用半精度浮点数(FP16)代替全精度浮点数(FP32)进行计算和存储可以减少内存占用并提高计算速度。同时结合FP32进行梯度累积和权重更新可以保证模型的准确性不受影响。

- 分布式优化算法:传统的梯度下降算法在多GPU环境下可能存在收敛速度慢的问题。可以使用更先进的分布式优化算法如Adam、RMSprop等来加快收敛速度并提高模型性能。

- 通信优化:在进行梯度同步时,可以利用高效的通信库(如NCCL)和优化的网络拓扑结构来降低通信延迟和带宽开销。此外还可以通过压缩梯度或使用稀疏通信技术来进一步减少通信成本。

- 负载均衡:由于不同GPU之间的计算能力可能存在差异因此在分配任务时需要考虑负载均衡以避免某些GPU过载而其他GPU闲置的情况发生。可以通过动态调整任务分配比例或引入优先级队列等方式来实现负载均衡。

四、总结与展望

通过实施上述多GPU并行优化策略我们可以有效地提升BERT模型在多GPU环境下的训练速度和性能表现。然而在实际应用中可能还会遇到各种复杂的问题和挑战需要我们不断地探索和创新以寻求更加高效可靠的解决方案。展望未来随着硬件技术的不断进步和算法的不断优化我们有理由相信多GPU并行将成为加速大型深度学习模型训练的主流手段之一为自然语言处理等人工智能领域的研究和发展提供强大的动力支持。

随着深度学习技术的飞速发展,预训练语言模型如BERT(Bidirectional Encoder Representations from Transformers)已成为自然语言处理领域的重要基石。然而,BERT模型由于其庞大的参数数量和复杂的计算需求,对计算资源的要求极高。为了加速BERT的训练过程,利用多个GPU进行并行计算成为了一种有效的解决方案。本文将探讨如何在多GPU环境下实现BERT模型的并行训练,以及如何优化这一过程以获得最佳性能。

一、多GPU并行原理

在单GPU环境中,所有的计算任务都在一个GPU上执行。而在多GPU环境中,可以将计算任务分配到多个GPU上同时进行,从而显著提高计算速度。具体来说,可以通过以下两种方式实现多GPU并行:

- 数据并行:将输入数据集分割成若干个子集,每个子集分配到一个GPU上进行计算。这种方式适用于大规模数据集,可以有效减少单个GPU的计算负担。

- 模型并行:将模型的不同部分分配到不同的GPU上进行计算。这种方式适用于模型规模较大的情况,可以避免单个GPU的显存不足问题。

二、BERT模型的多GPU并行实现

对于BERT模型而言,由于其Transformer结构的复杂性,通常采用数据并行的方式进行多GPU训练。以下是实现BERT模型多GPU并行的基本步骤:

- 数据准备:首先需要将输入数据集分割成若干个子集,每个子集包含相同数量的样本。这些子集将被分别发送到不同的GPU上进行训练。

- 初始化模型:在每个GPU上初始化一个相同的BERT模型副本。这些模型副本将在各自的GPU上进行前向传播和反向传播计算。

- 梯度同步:在每个训练批次结束后,需要将所有GPU上的模型副本的梯度进行同步。这可以通过求取所有梯度的平均值来实现,以确保不同GPU上的模型副本能够朝着同一方向更新权重。

- 权重更新:使用同步后的梯度对所有GPU上的模型副本进行权重更新。这一步骤可以确保所有模型副本在下一轮训练中具有相同的权重值。

- 重复以上步骤直至模型收敛。

三、多GPU并行优化策略

尽管多GPU并行可以显著提高BERT模型的训练速度,但如果不进行适当的优化,可能会遇到一些性能瓶颈。以下是一些常用的多GPU并行优化策略:

- 梯度累积:由于梯度同步操作的开销较大,可以通过累积多个训练批次的梯度后再进行一次同步来降低同步频率。这种方法可以在一定程度上缓解梯度同步带来的性能损失。

- 混合精度训练:使用半精度浮点数(FP16)代替全精度浮点数(FP32)进行计算和存储可以减少内存占用并提高计算速度。同时结合FP32进行梯度累积和权重更新可以保证模型的准确性不受影响。

- 分布式优化算法:传统的梯度下降算法在多GPU环境下可能存在收敛速度慢的问题。可以使用更先进的分布式优化算法如Adam、RMSprop等来加快收敛速度并提高模型性能。

- 通信优化:在进行梯度同步时,可以利用高效的通信库(如NCCL)和优化的网络拓扑结构来降低通信延迟和带宽开销。此外还可以通过压缩梯度或使用稀疏通信技术来进一步减少通信成本。

- 负载均衡:由于不同GPU之间的计算能力可能存在差异因此在分配任务时需要考虑负载均衡以避免某些GPU过载而其他GPU闲置的情况发生。可以通过动态调整任务分配比例或引入优先级队列等方式来实现负载均衡。

四、总结与展望

通过实施上述多GPU并行优化策略我们可以有效地提升BERT模型在多GPU环境下的训练速度和性能表现。然而在实际应用中可能还会遇到各种复杂的问题和挑战需要我们不断地探索和创新以寻求更加高效可靠的解决方案。展望未来随着硬件技术的不断进步和算法的不断优化我们有理由相信多GPU并行将成为加速大型深度学习模型训练的主流手段之一为自然语言处理等人工智能领域的研究和发展提供强大的动力支持。