GPU加速矩阵计算的威力

人工智能

2024-06-23 06:00

289

联系人:

联系方式:

随着科技的飞速发展,图形处理器(GPU)已经成为了计算机领域中不可或缺的一部分。GPU最初被设计用于处理图形渲染任务,但随着技术的进步,它现在也被广泛应用于各种计算密集型任务,如深度学习、科学计算等。其中,矩阵计算是GPU应用的一个重要领域。本文将探讨如何利用GPU进行高效的矩阵计算。

一、GPU与CPU的区别

我们需要了解GPU和CPU之间的主要区别。CPU通常具有较少的内核,但每个内核都可以执行复杂的指令集。这使得CPU非常适合处理逻辑和控制流密集型的任务。相比之下,GPU具有大量的内核,但每个内核只能执行相对简单的指令集。这种架构使得GPU在处理大量并行计算任务时具有极高的效率。

二、矩阵计算的并行性

矩阵计算是一种典型的并行计算任务。例如,矩阵乘法可以分解为多个子任务,每个子任务只涉及矩阵的一小部分。这意味着我们可以将这些子任务分配给GPU的多个内核,从而实现并行计算。通过这种方式,GPU可以在短时间内完成大量的矩阵计算任务,大大提高了计算速度。

三、CUDA编程模型

为了充分利用GPU的计算能力,我们需要使用一种名为CUDA的编程模型。CUDA是由NVIDIA公司开发的一种并行计算平台和编程模型,它允许开发者直接使用C或C 语言编写代码,并在GPU上运行。通过CUDA,我们可以轻松地将矩阵计算任务分配到GPU的各个内核上,实现高效的并行计算。

四、案例研究:矩阵乘法

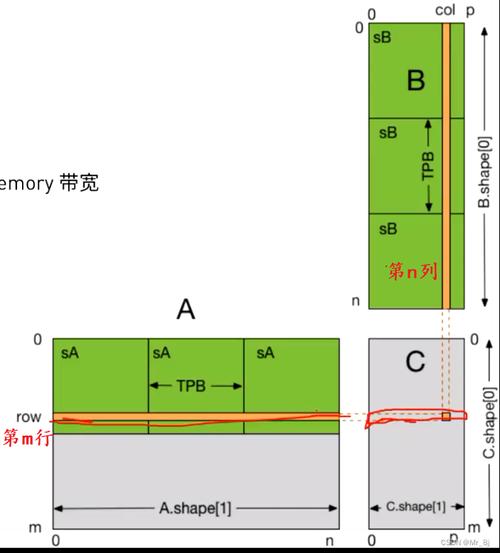

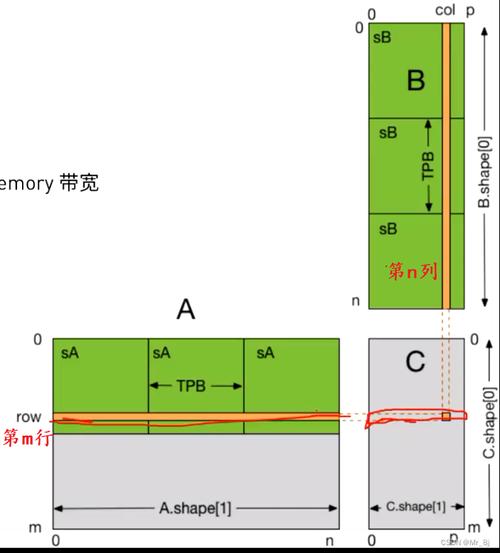

让我们以矩阵乘法为例,看看如何使用CUDA在GPU上进行高效的矩阵计算。假设我们有两个大小分别为N×N的矩阵A和B,我们想要计算它们的乘积C。在CPU上,这个任务的复杂度为O(N^3),而在GPU上,我们可以将其分解为N^2个子任务,每个子任务只涉及矩阵的一小部分。这样,我们就可以将这些子任务分配给GPU的多个内核,实现并行计算。通过这种方式,GPU可以在短时间内完成大量的矩阵乘法任务,大大提高了计算速度。

五、结论

利用GPU进行矩阵计算是一种非常有效的方法。通过将计算任务分解为多个子任务并将其分配给GPU的多个内核,我们可以实现高效的并行计算。使用CUDA编程模型可以使这个过程变得更加简单和直观。在未来,随着GPU技术的不断发展和优化,我们有理由相信GPU将在更多领域发挥其强大的计算能力。

随着科技的飞速发展,图形处理器(GPU)已经成为了计算机领域中不可或缺的一部分。GPU最初被设计用于处理图形渲染任务,但随着技术的进步,它现在也被广泛应用于各种计算密集型任务,如深度学习、科学计算等。其中,矩阵计算是GPU应用的一个重要领域。本文将探讨如何利用GPU进行高效的矩阵计算。

一、GPU与CPU的区别

我们需要了解GPU和CPU之间的主要区别。CPU通常具有较少的内核,但每个内核都可以执行复杂的指令集。这使得CPU非常适合处理逻辑和控制流密集型的任务。相比之下,GPU具有大量的内核,但每个内核只能执行相对简单的指令集。这种架构使得GPU在处理大量并行计算任务时具有极高的效率。

二、矩阵计算的并行性

矩阵计算是一种典型的并行计算任务。例如,矩阵乘法可以分解为多个子任务,每个子任务只涉及矩阵的一小部分。这意味着我们可以将这些子任务分配给GPU的多个内核,从而实现并行计算。通过这种方式,GPU可以在短时间内完成大量的矩阵计算任务,大大提高了计算速度。

三、CUDA编程模型

为了充分利用GPU的计算能力,我们需要使用一种名为CUDA的编程模型。CUDA是由NVIDIA公司开发的一种并行计算平台和编程模型,它允许开发者直接使用C或C 语言编写代码,并在GPU上运行。通过CUDA,我们可以轻松地将矩阵计算任务分配到GPU的各个内核上,实现高效的并行计算。

四、案例研究:矩阵乘法

让我们以矩阵乘法为例,看看如何使用CUDA在GPU上进行高效的矩阵计算。假设我们有两个大小分别为N×N的矩阵A和B,我们想要计算它们的乘积C。在CPU上,这个任务的复杂度为O(N^3),而在GPU上,我们可以将其分解为N^2个子任务,每个子任务只涉及矩阵的一小部分。这样,我们就可以将这些子任务分配给GPU的多个内核,实现并行计算。通过这种方式,GPU可以在短时间内完成大量的矩阵乘法任务,大大提高了计算速度。

五、结论

利用GPU进行矩阵计算是一种非常有效的方法。通过将计算任务分解为多个子任务并将其分配给GPU的多个内核,我们可以实现高效的并行计算。使用CUDA编程模型可以使这个过程变得更加简单和直观。在未来,随着GPU技术的不断发展和优化,我们有理由相信GPU将在更多领域发挥其强大的计算能力。